编写组 | 韩阳、范月灿、毛莉、曹翔

如今,这个世界已经变成了一个机器思考、学习和创造的世界。而且,它们做这些事情的能力将迅速提高,在不久的将来,它们能够解决的问题范围将随着人类思维的应用范围而扩大。

—赫伯特·西蒙,1957 年

2017年1月14日,在德克萨斯数据日大会上,Deep Grammar联合创始人、首席执行官、人工智能专家、机器学习专家Jonathan Mugan发表了题为《深度学习用于自然语言处理》的演讲。

Jonathan Mugan 的演讲主要关注人工智能、机器学习和自然语言处理的结合,在本次演讲中他重点讲解了如何从自然语言处理走向人工智能,以及两种具体的路径:符号路线和亚符号路线。

本文根据该演讲64页PPT中文翻译版,点击右上角进入大数据文摘后台,回复“自然语言处理”即可获取完整版演讲PPT。

人工智能已经变得更加智能,特别是深度学习,但计算机仍然无法智能地阅读或说话。

要理解语言,计算机需要理解世界。它们需要回答以下问题:

为什么用绳子可以拉车,却不能推车呢?

为什么体操运动员不常单腿参加比赛?

为什么只有外面下雨?

如果桌子上有一本书,你推桌子,会发生什么?

如果鲍勃去垃圾场,他会去机场吗?

让我们以基于感觉和行动的方式来理解语言 -

当有人说“鸡”时,我们会直接将其与我们对鸡的经验联系起来。我们彼此理解,因为我们有相同的经验,而这正是计算机所需要的理解。

理解含义的两条路径:

无意义的标记

词袋表示:

将单词视为任意符号并查看其频率。“狗咬人”和“人咬狗”完全相同。考虑一个包含 50,000 个单词的词汇表:

“aardvark” 的位置是 0

“ate” 的位置是 2

“动物园” 的排名是 49,999

一个词袋可以是一个具有 50,000 维的向量。

“土豚吃掉了动物园。” = [1,0,1,...,0,1]

通过计算这些词出现的频率,我们可以做得更好一些。

tf:词频,即词语出现的频率。

“土豚吃掉了动物园旁边的土豚。” = [2,0,1,...,0,1]

推广不常见的单词:

我们可以认为不常见的单词比常见的单词更能。。文本,从而获得更好的结果。将每个条目乘以一个度量,该度量表示它在语料库中的常见程度。

idf:逆文档频率索引

idf(术语,文本) = log(文本数量/包含术语的文本数量)

10 篇文本中,只有一篇有“土豚”,5 篇有“动物园”,5 篇有“吃”

tf-idf:tf * idf

“土豚吃掉了动物园旁边的土豚。” =[4.6,0,0.7, ..., 0, 0.7]

这叫做向量空间模型。你可以将这些向量输入到任何分类器中,或者根据相似的向量找到相似的文档。

主题模型(LDA):

潜在狄利克雷分配

您选择主题的数量,每个主题都是单词的分布,每个文档都是主题的分布,这在 Python 主题模型 gensim 中很容易做到()

使用 pyLDAvis 在 Twitter 上应用 LDA:

情感分析:作者对文本有何感受?

手动设置表达式

我们通过手动指定符号之间的关系来告诉计算机事物的含义。

1. 使用预先确定的关系来存储含义

2. 说明多种写作方式

通过相对较少的表达式,我们就可以编码机器应该做的事情。

WordNet:

框架网络:

概念网络:

另一个本体:

建议合并的本体:

图像模式:

图像图式是人类对跨文化共同经验的表征。

—费尔德曼,2006 年

人类使用图像图式来理解空间排列和运动

—曼德勒,2004年

意象图式的例子包括路径、先知、障碍和吸引力

—约翰逊,1987 年

浪漫关系和争论等抽象概念被用作这种体验的隐喻。

—Lakoff 和 Johnson,1980 年

语义网-链接数据:

世界模型

计算机需要因果模型来解释世界如何运作以及如何与之互动。人们不会为了传达信息而说出一切,只会说出我们共同概念未涵盖的内容。编码我们共同概念的最有效方法是借用模型。模型表达了世界如何根据。。发生变化。回顾商业购买框架,后来,一个人有更多的钱,另一个人有更少的钱,结论就是从模型中读出的。

模型纬度:

概率:确定性与随机性。例如,逻辑与概率编程

因子状态:整体状态和所用变量的比较。例如,有限自动机和动态贝叶斯网络的比较

相关性:命题逻辑和一阶逻辑。例如,贝叶斯网络和马尔可夫逻辑网络

并发:将一个事物模型与多个事物进行比较。例如,将有限自动机与 Petri 网进行比较

时间:静态 vs. 动态。例如贝叶斯网络 vs. 动态贝叶斯网络

通过将表达式与模型合并:

Word2vec

Word2vec 模型为词汇表中的每个单词学习一个向量。每个词向量的维度相同,通常在 300 左右。与 tf-idf 向量不同,词向量紧凑,并且大多数值不为零。

1. 将每个单词初始化为随机向量

2. 对于文档集中的每个单词 w1:

3. 对于单词 w1 周围的每个单词 w2:

4. 移动向量,使得 w1 和 w2 更近,而其他单词距离 w1 更远。

5.如果不满足终止条件,则跳转到步骤2

——Skip-gram模型(Mikolov等,2013)

注意:每个单词实际上有两个向量,因为你不希望单词靠近它自己。(参见 Goldberg 和 Levy)这个双 for 循环解释来自 Christopher Moody

word2vec的含义:

我们经常会看到这样的名言:

“你可以通过观察一个单词周围的其他单词来理解它”

——JR·弗斯 1957年

从某种意义上来说,这似乎是正确的。

“向量具有内部结构。”

——Mikolov 等,2013 年

意大利 – 罗马 = 法国 – 巴黎

国王 – 王后 = 男人 – 女人

但是……词语不是基于经验,而只是基于周围的其他词语。

(您也可以在 ConceptNe 上执行 word2vec,请参阅 /pdf/1612.03975v1.pdf)

Seq2seq 模型

seq2seq(序列到序列)模型可以将符号序列(例如句子)编码为向量。反过来,该模型可以将向量解码为另一个符号序列。编码和解码都可以使用循环神经网络 (RNN) 完成。一个明显的应用是机器翻译。例如,源语言是英语,目标语言是西班牙语。

将句子含义编码成向量:

解码句子:

生成图像标题:

回答提问

兴趣点:

深度学习和问答:

神经网络学习符号序列之间的联系,但这种描述不足以涵盖现实世界中丰富的联系。

外部世界训练

如果我们想与机器交流,我们需要在尽可能与我们相似的环境中训练它们。而不仅仅是对话!(Harnad [1990])为了理解“鸡”,我们需要机器尽可能多地了解“鸡”。当我们说“鸡”时,我们不仅仅指鸡,还指我们可以用它做的所有事情,以及它在我们的文化中所具有的所有含义。

在此方向上已经做了很多工作:

首先,在工业领域——

1. OpenAI

世界:通过 VNC(远程桌面)在屏幕上进行培训

现在是通过侠盗猎车手!

()

2.谷歌

Mikolov 等人,《机器智能路线图》。

它们定义了一个人工环境。()

3. Facebook

Weston,《对话记忆网络》

Kiela 等人,《虚拟体现:人工智能的可扩展长期战略》研究。提倡“有目的地”使用电子游戏

当然还有学术界——

1. 雷·穆尼

将文本映射到情况

2.卢克·斯蒂尔斯

具有词汇和简单语法的机器人

3. Narasimhanet 等。

训练神经网络玩基于文本的冒险游戏

然而,我们需要针对现实世界进行更多的训练:

也许等到亚马逊 Alexa 有了摄像头和可以移动的头之后,我们能在没有老师指导的情况下走多远呢?

我们可以利用目光作为信息来源吗?

——Yu 和 Ballard,[2010]

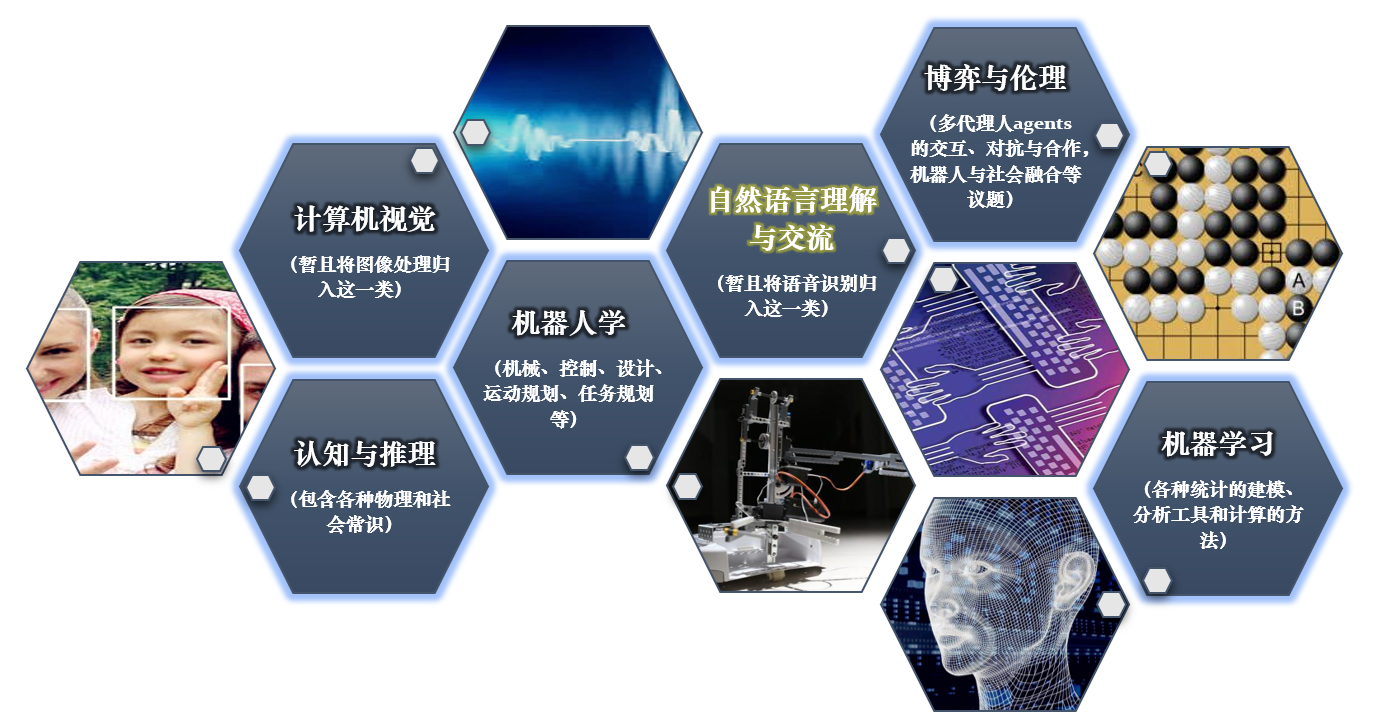

从 NLP 到 AI 的两条路径

最后的想法

开放式问题:

从商业角度来看,需要运用常识和逻辑推理的最简单的任务是什么?

关于转载 如需转载,请在开篇显著位置注明作者和出处(转自:大数据文摘 |bigdatadigest),并在文章结尾放置大数据文摘醒目二维码。无原创标识文章请按照转载要求编辑,可直接转载,转载后请将转载链接发送给我们;有原创标识文章,请发送【文章名称-待授权公众号名称及ID】给我们申请白名单授权。未经许可的转载以及改编者,我们将依法追究其法律责任。联系邮箱:zz@bigdatadigest.cn。 志愿者介绍

标题:从自然语言处理到人工智能的两条路径(附64页PPT)语言处理自然属性包括链接:https://www.ltthb.com/news/xydt/121728.html版权:文章转载自网络,如有侵权,请联系删除!